Ισχυρή Χωρική Συχνότητα Κοινής Εκπροσώπησης για Ταξινόμηση Δορυφορικής Εικόνας

Από RemoteSensing Wiki

Ισχυρή Χωρική Συχνότητα Κοινής Εκπροσώπησης για Ταξινόμηση Δορυφορικής Εικόνας

Robust Space–Frequency Joint Representation for Remote Sensing Image Scene Classification

Jie Fang , Yuan Yuan, Senior Member, IEEE, Xiaoqiang Lu , Senior Member, IEEE, and Yachuang Feng IEEE TRANSACTIONS ON GEOSCIENCE AND REMOTE SENSING, VOL. 57, NO. 10, OCTOBER 2019, 7492

Ως ταξινόμηση των δορυφορικών εικόνων χαρακτηρίζεται η διαδικασία της αυτοματοποιημένης κατηγοριοποίησης των αντικειμένων που απεικονίζονται σε μια δορυφορική εικόνα με την απόδοση μιας σημασιολογίας, με βάση τα χαρακτηριστικά που έχουν. Παρά την τεχνολογική εξέλιξη που λαμβάνει χώρα τις τελευταίες δεκαετίες στον τομέα των δορυφορικών συστημάτων, ο τομέας τα αυτοματοποιημένης ταξινόμησης δεν είχε γνωρίσει ανάλογη πορεία μέχρι πρόσφατα, αποτελώντας με αυτόν τον τρόπο ένα θεμελιώδες πρόβλημα για την επιστήμη, καθώς η συνεισφορά της σ’ ένα εύρος εφαρμογών θα ήταν τεράστια.

Ένας εκ των τομέων που επωφελήθηκαν από την ραγδαία ανάπτυξη της επιστήμης των νευρονικών δικτύων και της τεχνητής νοημοσύνης είναι και αυτός της ταξινόμησης δορυφορικών εικόνων καθώς βοήθησε ως προς την ενίσχυση των αυτοματοποιημένων διαδικασιών για την κατηγοριοποίηση των αντικειμένων. Η παρούσα έρευνα στοχεύει στην βελτίωση των αποτελεσμάτων της κατηγοριοποίησης των αντικειμένων, αξιοποιώντας τα διακριτά αντικείμενα από το χωρικό τμήμα της εικόνας, μέσω της χρήσης ενός αυτό-εκπαιδευόμενου αλγορίθμου, ο οποίος εκπαιδεύεται με βάση ένα κομμάτι των εικόνων που έχουν παραχωρηθεί και προχωρά στην ανάλυση των υπολοίπων με βάση τα μοτίβα και τις ομάδες που έχει χτίσει. Η μέθοδος συνολικά βασίστηκε σε 4 δημόσιες ομάδες δεδομένων, οι οποίες ήταν οι Sydney, UC-Merced, WHU-RS19 και AID.

Βασικό κομμάτι της έρευνας αποτέλεσαν οι περιορισμοί που έπρεπε να τεθούν. Πιο συγκεκριμένα, παρά το γεγονός ότι η τεχνητή νοημοσύνη και τα νευρονικά δίκτυα προσφέρουν καλύτερα αποτελέσματα απ’ ότι η χειροκίνητη ταξινόμηση με βάση τα χαρακτηριστικά των αντικειμένων, κάποιοι περιορισμοί παραμένουν.

Ο πρώτος αφορά, την σύγκριση μεταξύ δυο εικόνων με διαφορά χαρακτηριστικά, σύγκριση κατά την οποία το μοντέλο έχει εκπαιδευτεί σε μια εκ των δυο, οδηγώντας με αυτό τον τρόπο σε λανθασμένη κατηγοριοποίηση της δεύτερης (1 & 2).

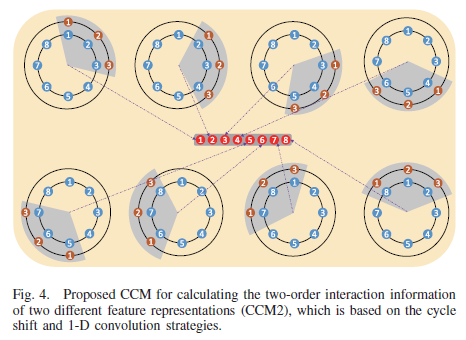

Ο δεύτερος περιορισμός αφορά το γεγονός πως παρότι κάποιες μέθοδοι χρησιμοποιούν παγκόσμια ή τοπικά χαρακτηριστικά ταυτοχρόνως, στην τελική απεικόνιση αποτυγχάνουν να αναλύσουν τις μεταξύ τους γειτνιάσεις , οδηγώντας σε πολλές περιπτώσεις σε λανθασμένη κατηγοριοποίηση (3, 4 & 5).

Τέλος, η αυτοματοποιημένη κατηγοριοποίηση των αντικειμένων βασίζεται στην χρήση ενός τμήματος της εικόνας ή του συνόλου των εικόνων που παρέχονται στο σύστημα. Σε αυτές τις περιπτώσεις, το τμήμα που θα χρησιμοποιηθεί έχει πολύ σημαντικό ρόλο καθώς επηρεάζει και το τελικό αποτέλεσμα της κατηγοριοποίησης αυτής κάθε αυτής, καθώς κάθε επανάληψη του μοντέλου δύναται να παράξει διαφορετικό αποτέλεσμα (6, 7).

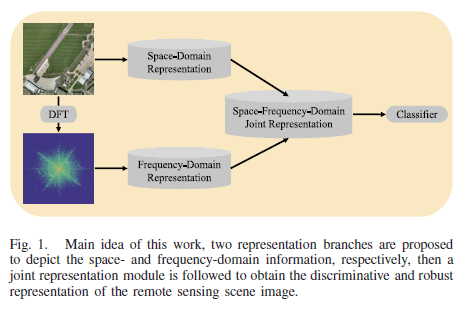

Προκειμένου να εξαλειφθούν σε όσο μεγαλύτερο βαθμό γίνεται οι προαναφερθέντες περιορισμοί η ομάδα προχώρησε σε συγκεκριμένα βήματα ώστε να πετύχει την έρευνα της. Χρησιμοποιώντας ένα πρόγραμμα χωρικής παρουσίασης (Spatial-Domain Representation Module - SDRM) στόχευσε στον συνδυασμό τόσο των τοπικών όσο και των παγκόσμιων αντικειμένων, προκειμένου να παραχθεί ένα μοντέλο εξομάλυνσης των διαφορών.

Στοχεύοντας στην ορθότερη κατηγοριοποίηση του παραγόμενου προϊόντος, αποφασίστηκε να χρησιμοποιηθεί ο χάρτης συχνότητας της αρχικής εικόνας ούτως ώστε να αποτυπωθεί όσο αποτελεσματικότερα γίνεται η πληροφορία στην τελική εικόνα. (8 & 9). Κατά την χρήση αυτής της μεθόδου παρατηρήθηκε βελτίωση της ποιότητας της τελικής εικόνας, λόγω της χρήσης μιας απλουστευμένης δομής της αρχικής εικόνας. Μέσω του συνδυασμού των δυο αυτών μεθόδων προσπαθούν να αξιοποιήσουν τόσο τον χωρικό τομέα, όσο και τον τομέα συχνοτήτων της εικόνας, για την ορθότερη απεικόνιση της τελικής εικόνας.

Κατά την πραγματοποίηση των δοκιμών χρησιμοποιήθηκαν 4 σύνολα δεδομένων, κάθε ένα εκ των οποίων αποτελούταν από σύνολο εικόνων, οι οποίες με την σειρά τους ήταν χωρισμένες σε 7 διαφορετικά bands, ενώ η χωρική τους ανάλυση βρισκόταν στα 500x500. Κατά την εκπαίδευση του αλγορίθμου χρησιμοποιούταν για κάθε σύνολο δεδομένων το 50% των εικόνων ώστε να επιτευχθεί όσο των δυνατόν αποτελεσματικότερη ταξινόμηση (10 & 11). Για την πολλαπλή ανάλυση των δεδομένων ακολουθήθηκε μια πολύπλευρη προσέγγιση για το κάθε’ ένα προκειμένου να ελεγχθούν τα αποτελέσματα τους και να εξαχθούν ασφαλέστερα συμπεράσματα, με ένα εκ των οποίων να είναι το προτεινόμενο μοντέλο, ενώ τα υπόλοιπα αποτελούσαν καθιερωμένα στο πεδίο μοντέλα κατηγοριοποίησης (12). Τα μοντέλα ελέγχθηκαν με βάση 3 διαφορετικά κριτήρια; Συνολική ακρίβεια, Ταξική ακρίβεια και τυπική απόκλιση.

Συνολικά, το προτεινόμενο μοντέλο με βάση τους 3 δείκτες που χρησιμοποιήθηκαν φαίνεται να κατάφερε να βελτιώσει τα αποτελέσματα των κατηγοριοποιήσεων, κάτι το οποίο ωστόσο δεν αποδεικνύει την ανωτερότητα του μοντέλου με βάση τα υπόλοιπα. Στο σύνολο δεδομένων του Sydney επέτυχε βελτίωση της τάξεως του 1.64% σε σύγκριση με τα υπόλοιπα μοντέλα, στου UC-Merced βελτίωση της τάξης 1.69%, στου WHU-RS19 μόλις 0.11% και τέλος τα θεαματικότερα αποτελέσματα επιτεύχθηκαν στο AID, με ποσοστό που αγγίζει το 2.85%. Παρά την επιτυχία της μεθόδου, ο λόγος που δεν μπορεί ακόμα να αποδειχθεί η καθολικότητα της στο πεδίο της κατηγοριοποίηση αποτελεί το γεγονός πως πρέπει να δοκιμαστεί σε περισσότερα σύνολα δεδομένων και να μελετηθεί η ακρίβεια των αποτελεσμάτων της.

Εν κατακλείδι, το προτεινόμενο μοντέλο κάνει χρήση της χωρικής πληροφορίας της κάθε εικόνας, κωδικοποιώντας τις σχέσεις μεταξύ διαφορετικών τοπικών περιοχών και τις αλληλεπιδράσεις μεταξύ διαφορετικών παγκόσμιων χαρακτηριστικών των αντικειμένων μέσα στο χωρικό σύνολο. Επιπροσθέτως, η στατιστική συχνότητα παρουσίασης των αντικειμένων χρησιμοποιείται για την τελική παρουσίαση, απεικονίζοντας αποτελεσματικά τις σχέσεις μεταξύ των αντικειμένων. Τα αποτελέσματα της έρευνας ανοίγουν ένα νέο μονοπάτι στον τομέα της αυτοματοποιημένης κατηγοριοποίησης αντικειμένων από δορυφορικές εικόνες, με την χρήση νευρωτικών δικτύων και της τεχνητής νοημοσύνης, καθώς απέδειξαν πως σε ένα μικρό δείγμα δεδομένων πως μπορεί να επιτευχθεί αποτελεσματικότερη ταξινόμηση από τις μέχρι τώρα υπάρχουσες μεθόδους.

Βιβλιογραφία

(1) F. P. S. Luus, B. P. Salmon, F. Van Den Bergh, and B. T. J. Maharaj, “Multiview deep learning for land-use classification,” IEEE Geosci. Remote Sens. Lett., vol. 12, no. 12, pp. 2448–2452, Dec. 2015. doi: 10.1109/LGRS.2015.2483680.

(2) N. Yang, H. Tang, H. Sun, and X. Yang, “DropBand: A simple and effective method for promoting the scene classification accuracy of convolutional neural networks for VHR remote sensing imagery,” IEEE Geosci. Remote Sens. Lett., vol. 15, no. 2, pp. 257–261, Feb. 2018. doi: 10.1109/LGRS.2017.2785261

(3) Q. Zhu, Y. Zhong, Y. Liu, L. Zhang, and D. Li, “A deep-localglobal feature fusion framework for high spatial resolution imagery scene classification,” Remote Sens., vol. 10, no. 4, p. 568, 2018. doi: 10.3390/rs10040568.

(4) G. Cheng, C. Yang, X. Yao, L. Guo, and J. Han, “When deep learning meets metric learning: Remote sensing image scene classification via learning discriminative CNNs,” IEEE Trans. Geosci. Remote Sens., vol. 56, no. 5, pp. 2811–2821, May 2018. doi: 10.1109/TGRS.2017.2783902.

(5) G. Cheng, Z. Li, X. Yao, L. Guo, and Z. Wei, “Remote sensing image scene classification using bag of convolutional features,” IEEE Geosci. Remote Sens. Lett., vol. 14, no. 10, pp. 1735–1739, Oct. 2017. doi: 10.1109/LGRS.2017.2731997.

(6) G. Cheng, P. Zhou, and J. Han, “Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images,” IEEE Trans. Geosci. Remote Sens., vol. 54, no. 12, pp. 7405–7415, Dec. 2016. doi: 10.1109/TGRS.2016. 2601622.

(7) Q. Liu, R. Hang, H. Song, and Z. Li, “Learning multiscale deep features for high-resolution satellite image scene classification,” IEEE Trans. Geosci. Remote Sens., vol. 56, no. 1, pp. 117–126, Jan. 2017. doi: 10.1109/TGRS.2017.2743243.

(8) J. Ren et al., “Look, listen and learn—A multimodal LSTM for speaker identification,” in Proc. 13th AAAI Conf. Artif. Intell., Phoenix, AZ, USA, Feb. 2016, pp. 3581–3587. [Online]Available:http://www.aaai.org/ocs/index.php/AAAI/AAAI16/paper/view/12386

(9) H. Phan, L. Hertel, M. Maass, and A. Mertins, “Robust audio event recognition with 1-max pooling convolutional neural networks,” in Proc. Interspeech, San Francisco, CA, USA, Apr. 2016, pp. 3653–3657. doi: 10.21437/Interspeech.2016-123.

(10) F. Zhang, B. Du, and L. Zhang, “Saliency-guided unsupervised feature learning for scene classification,” IEEE Trans. Geosci. Remote Sens., vol. 53, no. 4, pp. 2175–2184, Apr. 2015. doi: 10.1109/TGRS.2014.2357078.

(11) Y. Yang and S. Newsam, “Bag-of-visual-words and spatial extensions for land-use classification,” in Proc. 18th SIGSPATIAL Int. Conf. Adv. Geographic Inf. Syst., San Jose, CA, USA, Nov. 2010, pp. 270–279. doi: 10.1145/1869790.1869829.

(12) G.-S. Xia, W. Yang, J. Delon, Y. Gousseau, H. Sun, and H. Maître, “Structural high-resolution satellite image indexing,” in Proc. 7th Symp. ISPRS TC, Jul. 2010, pp. 298–303.